Los textos y las imágenes generados por IA están inundando la web, una tendencia que, irónicamente, podría ser un gran problema para los modelos de IA generativa.

Como escribe Aatish Bhatia para The New York Times , cada vez hay más investigaciones que demuestran que entrenar modelos de IA generativos con contenido generado por IA hace que los modelos se erosionen. En resumen, entrenar con contenido de IA provoca un ciclo de aplanamiento similar a la endogamia; el investigador de IA Jathan Sadowski denominó el año pasado el fenómeno como «IA de los Habsburgo», en referencia a la famosa familia real endogámica de Europa.

Y según el NYT , la creciente ola de contenido de IA en la web podría hacer que sea mucho más difícil evitar este efecto aplanador.

Los modelos de IA consumen una cantidad ridícula de datos, y las empresas de IA han recurrido a grandes cantidades de datos extraídos de la web para entrenar a los voraces programas. Sin embargo, en la actualidad, ni las empresas de IA ni sus usuarios están obligados a incluir declaraciones de IA o marcas de agua en el contenido de IA que generan, lo que hace que sea mucho más difícil para los creadores de IA mantener el contenido sintético fuera de los conjuntos de entrenamiento de IA.

«La web se está convirtiendo en un lugar cada vez más peligroso para buscar datos», dijo al NYT Sina Alemohammad, estudiante de posgrado de la Universidad Rice, coautor de un artículo de 2023 que acuñó el término «MAD» (abreviatura de «Trastorno de autofagia modelo») para describir los efectos del autoconsumo de IA .

Entrevistamos a Alemohammad el año pasado , cuando se prestaba poca atención a los datos generados por IA que contaminaban los conjuntos de datos de IA, por lo que ha sido interesante ver cómo el tema ganaba atención.

Un ejemplo ciertamente muy divertido de los impactos de la endogamia en la IA señalado por el NYT fue tomado de un nuevo estudio, publicado el mes pasado en la revista Nature . Los investigadores, una cohorte internacional de científicos con sede en el Reino Unido y Canadá, primero pidieron a los modelos de IA que completaran el texto de la siguiente oración: «Para cocinar un pavo para el Día de Acción de Gracias, debes…»

El primer resultado fue normal, pero en la cuarta iteración el modelo ya estaba diciendo tonterías : «Para cocinar un pavo para el Día de Acción de Gracias, tienes que saber qué vas a hacer con tu vida si no sabes qué vas a hacer con tu vida si no sabes qué vas a hacer con tu vida…»

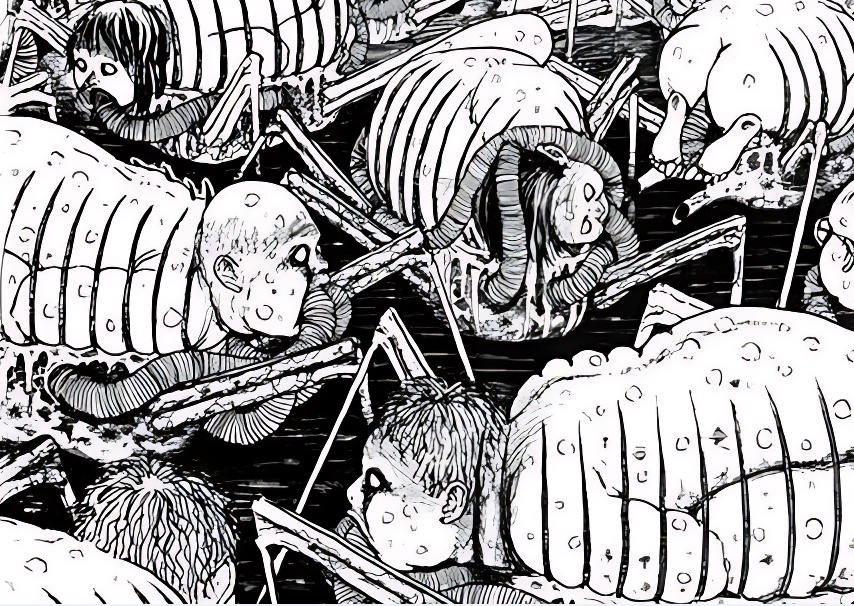

Pero el galimatías no es el único posible efecto secundario negativo del canibalismo de la IA. El estudio MAD, que se centró en modelos de imágenes, mostró que la introducción de resultados de IA con retratos humanos falsos provocó rápidamente una extraña convergencia de rasgos faciales; aunque los investigadores comenzaron con un conjunto diverso de rostros generados por IA, en el cuarto ciclo de generación (¿es ese un número mágico en IA, por alguna razón?) casi todos los rostros parecían iguales. Dado que el sesgo algorítmico ya es un gran problema, el riesgo de que la ingesta accidental de demasiado contenido de IA pueda contribuir a una menor diversidad en los resultados es muy alto.

Los datos de alta calidad y generados por humanos (y en gran cantidad) han sido fundamentales para los avances recientes en la tecnología de inteligencia artificial generativa existente. Pero, como el contenido generado por IA enturbia las aguas digitales y no hay una forma confiable de distinguir lo real de lo falso, las empresas de IA pronto podrían encontrarse chocando contra un muro peligroso .

–

FUENTE